En étudiant le calcul à plusieurs variables, on rencontre souvent l’utilisation de matrices pour représenter des notions différentes. On croise souvent la jacobienne, l’hessienne et le Gradient.

Ces notions sont proches les unes des autres, en vertu d’être des matrices ayant à voir avec des dérivées de fonctions. Cependant, chaque matrice a sa propre dérivation et sa propre signification.

Quelle est la différence entre la jacobienne, l’hessienne et le Gradient 🤔 ? Nous allons la découvrir ensemble lors de cet article. Au cours de ce voyage mathématique, on étudiera également les concepts de la différence entre des fonctions à valeurs vectorielles (vector valued functions) et des fonctions à valeurs scalaires (scalar valued functions).

Le Gradient

On commence par le gradient dont nous avons déjà parlé il y a quelques semaines. Le gradient est un vecteur composé des dérivées partielles d’une fonction à valeur scalaire, :

où s’appelle nabla. Il s’appelle parfois “del”. Il désigne l’opérateur différentiel vectoriel.

Rappelons que le gradient mesure la direction et le taux d’augmentation le plus rapide d’une fonction à un point donné.

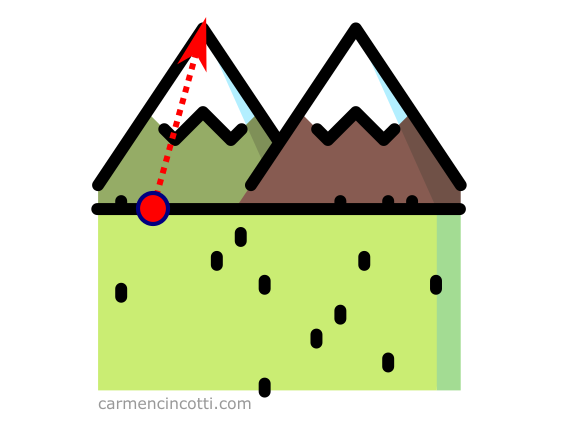

Imaginons que nous sommes au pied d’une montagne et que nous voulons la grimper le plus rapidement possible. On voit que la bonne piste est de la gravir dans le sens de la flèche :

Cette flèche représente le gradient parce que c’est l’ascension la plus rapide de la montagne.

Une fonction à valeur scalaire

Une fonction à valeur scalaire est une fonction (à plusieurs variables / de dimensions ) qui renvoie une valeur scalaire :

Par exemple, si nous évaluons au point (2,1), on reçoit le scalaire, 3 :

Comment calculer le Gradient

Prenons un exemple. J’ai une fonction définie comme . Tout d’abord, on doit trouver les dérivées partielles par rapport aux variables et comme suit :

Cela nous donne un gradient :

La hessienne

Si l’on suit bien l’explication du gradient, l’hessienne sera également facile à comprendre. C’est la dérivée du gradient d’une fonction à valeur scalaire . Par exemple :

En utilisant à nouveau la fonction , on verra une matrice hessienne comme suit :

Quelques applications de la matrice hessienne sont les suivantes :

-

Les approximations quadratiques d’une fonction à plusieurs variables. Il s’agit d’une approximation plus proche de la fonction que l’approximation linéaire locale dont nous avons déjà parlé il y a plusieurs semaines.

-

Le test de la seconde dérivée partielle - il est utilisé pour trouver les points-selles (point col), les maxima et les minima d’une fonction.

Le déterminant de Hesse

Le déterminant de Hesse joue un rôle dans la recherche des maxima/minima locaux d’une fonction à plusieurs variables. Nous verrons ce qu’il est un déterminant dans un article ultérieur. Pour l’instant, je vais juste expliquer comment le calculer. Je vous présente à nouveau la matrice hessienne que nous avons déjà calculée dans la partie dernière :

Afin de trouver le déterminant, nous devons suivre le framework ci-dessous :

Donc,

La jacobienne

La jacobienne est une matrice qui contient toutes les dérivées partielles du premier ordre d’une fonction à valeurs vectorielles :

La forme de la jacobienne d’une fonction à valeur vectorielle est donc la suivante :

Par exemple - si nous avons une fonction à valeurs vectorielles comme :

La matrice jacobienne serait :

En utilisant le jacobien, nous pouvons linéariser localement une fonction à valeur vectorielle en un point spécifique.

Les fonctions linéaires sont suffisamment simples pour que nous puissions bien les comprendre (en utilisant l’algèbre linéaire), et souvent comprendre l’approximation linéaire locale de f $$ lui-même.

Pour en savoir plus sur le calcul, voici une vidéo qui m’a beaucoup aidé :

Le déterminant de la matrice jacobienne

Nous pouvons utiliser la matrice jacobienne d’une transformation à valeur vectorielle pour trouver son déterminant. Pour ce faire avec une transformation de , on utilise le framework :

Prenons cet exemple en utilisant cette matrice jacobienne :

Nous pouvons calculer le déterminant comme suit :

Qu’est-ce que le déterminant signifie ? 🤔 La fonction nous donne l’amplitude dans laquelle l’espace se contracte ou s’élargir lors d’une transformation autour d’un point .

Par exemple, si on l’évalue au point , on verra :

Ce qui nous indique que l’espace ne change pas autour de ce point ! Cependant, autour du point , on voit une autre histoire :

Ainsi, autour de ce point, l’espace s’étend jusqu’à trois fois sa taille d’origine !

Je recommande cette ressource afin de visualiser les transformations et le déterminant pour chacune !

Des ressources (en français et anglais)

- Ask Ethan: What is A Scalar Field? - Forbes

- A Gentle Introduction To Hessian Matrices - Machine Learning Mastery

- A Gentle Introduction to the Jacobian - Machine Learning Mastery

- Vector and scalar functions and fields. Derivatives

- What is the Jacobian matrix? - Stack Exchange

- The Hessian - KhanAcademy

- What is the difference between the Jacobian, Hessian and the Gradient? - Stack Exchange